Was ist Web Scraping?

Web Scraping ist eine leistungsstarke Methode zum Extrahieren von Daten von Websites. Bei dieser Technik wird eine Software oder ein Web-Scraper verwendet, der automatisch auf einer Website navigiert, die erforderlichen Informationen abruft und für die spätere Verwendung extrahiert. Oft werden diese Daten zur weiteren Analyse in eine strukturierte Datenbank oder Tabelle umgewandelt. Die Bedeutung von Web Scraping liegt in seiner Fähigkeit, schnell eine große Datenmenge zu sammeln. In einer Welt, in der Daten eine wertvolle Wissens- und Machtquelle sind, ermöglicht Web Scraping Unternehmen und Einzelpersonen, relevante Informationen von Webseiten abzurufen, ohne sie manuell eingeben zu müssen. Dieser Prozess kann für eine Vielzahl von Zwecken angewendet werden, von Wettbewerbsinformationen bis hin zur Datenerfassung für die akademische Forschung. Die Wirksamkeit von Web Scraping hängt weitgehend von der Qualität des verwendeten Scrapers ab. Ein gutes Web-Scraping-Tool kann auf jeder Website navigieren und Daten von ihr extrahieren. Dabei werden häufig Maßnahmen umgangen, die den automatischen Zugriff auf Website-Daten verhindern oder einschränken. Software wie Octoparse ermöglicht es beispielsweise, diesen Prozess zu automatisieren und Web Scraping effektiver durchzuführen, indem Webdaten in strukturierte und leicht verwendbare Informationen umgewandelt werden.

Warum Web-Scraping-Software verwenden?

Die Verwendung von Web-Scraping-Software hat mehrere erhebliche Vorteile. Zuallererst spart es Zeit. Das manuelle Scrapen von Daten ist ein mühsamer und zeitaufwändiger Vorgang. Ein automatisierter Web Scraper kann diese Aufgabe in einem Bruchteil der Zeit erledigen, sodass sich die Benutzer auf die Analyse von Daten konzentrieren können, anstatt sie zu sammeln. Darüber hinaus garantiert die Web-Scraping-Software eine genaue und effiziente Datenerfassung. Im Gegensatz zur manuellen Datenerfassung, bei der menschliche Fehler auftreten können, kann ein Web-Scraper Daten mit großer Präzision extrahieren und so die Zuverlässigkeit der gesammelten Daten gewährleisten. Dies ist besonders wichtig in Bereichen, in denen genaue Daten von entscheidender Bedeutung sind, z. B. in der Marktforschung oder Finanzanalyse. Ein weiterer großer Vorteil ist die Möglichkeit, auf eine Vielzahl von Datenquellen zuzugreifen. Web-Scraping-Software kann Informationen von mehreren Websites abrufen, auch von Websites, auf die nicht leicht zugegriffen werden kann. Auf diese Weise können sich Unternehmen und Forscher ein vollständigeres Bild von der Informationslandschaft machen, die sie untersuchen, indem sie Daten von verschiedenen Websites extrahieren und in einer einzigen, strukturierten Datenbank zusammenfassen. Darüber hinaus sind Web-Scraping-Tools besonders nützlich, um Änderungen auf Websites im Laufe der Zeit zu verfolgen. Im Rahmen der Wettbewerbsanalyse kann ein Web-Scraper beispielsweise Preis- oder Produktänderungen auf Websites von Mitbewerbern überwachen und so aktuelle Daten bereitstellen, die für Geschäftsstrategien relevant sind. Schließlich ist Web Scraping für Unternehmen, die Daten in großem Umfang sammeln müssen, unerlässlich. Unternehmen, die für ihre Analysen wie Markttrends, Verbraucherpräferenzen oder Stimmungsanalysen auf die Erfassung von Daten angewiesen sind, werden Web-Scraper als unverzichtbares Tool zur effizienten und systematischen Extraktion von Daten empfinden.

1. Bardeen

Bardeen wird als leistungsstarke Automatisierungslösung für Ihre sich wiederholenden Aufgaben präsentiert, insbesondere im Bereich Web Scraping. Mithilfe künstlicher Intelligenz macht Bardeen die Automatisierung zu einer Aufgabe, die so einfach ist wie das Senden einer Nachricht. Diese Software bietet die Möglichkeit, automatisierte Workflows in wenigen Textzeilen zu erstellen und die Automatisierungen an Ihre spezifischen Bedürfnisse anzupassen. Sein Ansatz vermeidet manuelles Kopieren und Einfügen und erleichtert das Extrahieren von Daten von verschiedenen Websites. Bardeen zeichnet sich durch seine vielfältigen Funktionen aus, die die Produktivität verbessern und mit vielen gängigen Anwendungen kompatibel sind. Es ist in verschiedenen Preisplänen erhältlich, einschließlich einer kostenlosen Version, und ist ideal für Startups, Unternehmen und Online-Händler.

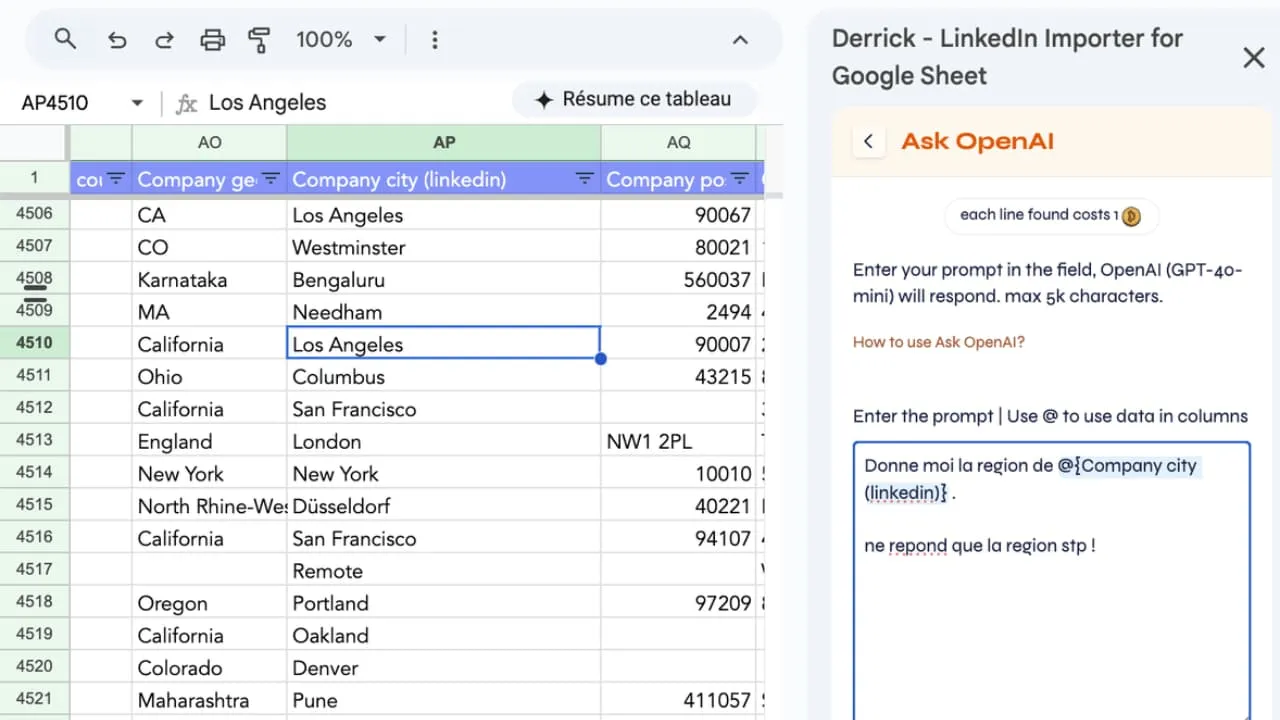

2. Derrick

Benutzen Derrick um Ihre Daten anzureichern und personalisierte Inhalte in Google Sheets zu generieren Derrick ist ein All-in-One-Tool zum Scraping, Anreichern und Automatisieren von KI, das direkt mit Google Sheets verbunden ist. Hier ist ein einfaches Beispiel, das die Leistungsfähigkeit des Tools bei der Akquise oder Inhaltsgenerierung mithilfe von KI veranschaulicht.

Rufen Sie zunächst Ihre Daten in einer Tabelle ab: eine Liste von Leads, Unternehmen oder Kontakten mit einem Klick. Derrick bietet erweiterte Anreicherungsfunktionen, mit denen Sie automatisch mehr als 100 Informationspunkte in jeder Zeile abrufen können: Name, Vorname, E-Mail, Telefon, Position, Website, geschätzter Traffic, LinkedIn-Profil usw.

Sobald diese Daten vorliegen, können Sie die Funktion askOpenAI oder askClaude verwenden, um personalisierte Inhalte in großem Maßstab zu generieren.

Beispiel für eine sehr einfach zu verwendende Aufforderung: Sie sind Experte für kalte E-Mails. Sie sprechen mit {{firstname}}, was {{job}} ist. Er hat Probleme mit {{painpoint}}. Ihr Service löst dieses Problem mit [Ihrer Lösung]. Schreiben Sie einen Eisbrecher in einem kurzen und aussagekräftigen Satz. Derrick ersetzt automatisch die Variablen ({{firstname}}}, {{job}}, {{painpoint}}) durch die spezifischen Werte jeder Zeile und generiert für jeden Kontakt eine eindeutige Nachricht.

Alles ohne Google Sheets zu verlassen.

Diese Art von Arbeitsablauf ermöglicht es, Rohdaten in großem Maßstab innerhalb von Minuten in kontextualisierten Inhalt umzuwandeln. Ein beachtlicher Vorteil für Wachstums-, Vertriebs-, Rekrutierungsteams oder alle, die den Einsatz von KI auf einfache und konkrete Weise industrialisieren möchten.

2. Durchsuchen Sie KI

Browse AI ist eine Plattform, die entwickelt wurde, um die Extraktion und Überwachung von Webdaten zu vereinfachen. Damit können Sie einen Roboter in nur zwei Minuten trainieren, ohne Programmierkenntnisse zu benötigen. Browse AI zeichnet sich dadurch aus, dass es bestimmte Daten von jeder Website extrahiert und in eine Tabelle konvertiert, die automatisch ausgefüllt wird. Die Plattform bietet auch eine Überwachungsfunktion, mit der Sie über Änderungen auf überwachten Websites informiert werden können. Mit vorgefertigten Robotern für gängige Anwendungsfälle eignet sich Browse AI besonders für Unternehmen, die nach einer effizienten und benutzerfreundlichen Lösung suchen.

3. Herr Scraper

MrScraper ist ein visuelles Web-Scraping-Tool, mit dem Daten einfach und ohne Blockierung von Websites extrahiert werden können. Mit einer intuitiven Benutzeroberfläche automatisiert es den mühsamen Scraping-Prozess. Durch die Verwendung echter Browser und Proxy-Rotation minimiert MrScraper Blockaden und bietet gleichzeitig Funktionen wie eine integrierte Planung und eine API für eine einfache Integration. Dank der Möglichkeit, ohne Code zu erstellen, ist die Datenextraktion für jeden zugänglich, von Einzelpersonen über Startups bis hin zu Unternehmen. MrScraper ist eine ideale Lösung für alle, die einen flexiblen und effektiven Ansatz für Web Scraping suchen.

4. Kadoa

Kadoa ist eine innovative Lösung, die die Extraktion von Webdaten mithilfe künstlicher Intelligenz erleichtert. Anstatt benutzerdefinierte Tools für jede Datenquelle zu erstellen, bietet Kadoa eine schnelle und genaue Methode, die an Änderungen der Website angepasst ist. Es transformiert und gewährleistet die Richtigkeit der extrahierten Daten und stellt sie über eine leistungsstarke API zur Verfügung. Aufgrund seiner Fähigkeit, Scraper automatisch zu generieren, und seines intelligenten Crawlings eignet sich Kadoa besonders für Unternehmen, die eine zuverlässige und skalierbare Datenextraktionslösung benötigen.

5. WebScrape KI

WebScrape AI wurde entwickelt, um die Online-Datenerfassung zu erleichtern, ohne dass Programmierkenntnisse erforderlich sind. Dieses intuitive und wirtschaftliche Tool passt sich den unterschiedlichen Bedürfnissen von Unternehmen an. Es ermöglicht eine einfache Anpassung der Datenerfassungspräferenzen und gewährleistet so genaue und zuverlässige Informationen. WebScrape AI automatisiert die Datenerfassung und spart so wertvolle Zeit. Der Benutzer muss nur die URL und die zu extrahierenden Elemente eingeben, das Tool kümmert sich um den Rest. Mithilfe fortschrittlicher Algorithmen wird eine genaue und zuverlässige Datenerfassung gewährleistet. WebScrape AI ist daher eine ideale Lösung für Unternehmen, die ihre Datenerfassung automatisieren und gleichzeitig Genauigkeit und Effizienz gewährleisten möchten.

Die Kriterien für die Auswahl der besten Web-Scraping-Software

Bei der Auswahl eines Web-Scraping-Software, mehrere Faktoren müssen berücksichtigt werden. Es ist von entscheidender Bedeutung, die zu bewerten Benutzerfreundlichkeit der Software, insbesondere für Benutzer ohne fortgeschrittene technische Fähigkeiten. Die angebotenen Funktionen wie die Automatisierung von Aufgaben, die Qualität der extrahierten Daten und die Fähigkeit, auf komplexen Websites zu navigieren, sind ebenfalls wichtig. Ein guter Kundensupport und regelmäßige Software-Updates sind unerlässlich, um eine reibungslose und effiziente Benutzererfahrung zu gewährleisten.

Wie mache ich Web Scraping legal?

Web Scraping kann rechtliche Probleme aufwerfen, insbesondere wenn es um Datenschutz- und Urheberrechtsfragen geht. Es ist wichtig, die in Ihrer Region geltenden Gesetze zu verstehen und die Nutzungsbedingungen der Zielwebsites einzuhalten. Der ethische Einsatz von Web Scraping beinhaltet auch die Vermeidung einer Überlastung der Site-Server und den Schutz personenbezogener Daten.

Die Vorteile eines einfach zu bedienenden Web Scrapers

Eins Web-Scraper einfach zu bedienen macht denDatenextraktion für ein breiteres Publikum zugänglich. Auf diese Weise können Benutzer ohne Programmierkenntnisse von den Vorteilen des Web Scraping profitieren, z. B. dem schnellen Zugriff auf relevante Daten und der Möglichkeit, Markttrends in Echtzeit zu verfolgen.

Kostenlose und kostenpflichtige Web-Scraper: Was ist der Unterschied?

Kostenlose Web-Scraper reichen oft für einfache und einmalige Aufgaben aus. Für komplexere und regelmäßigere Anforderungen bieten die kostenpflichtigen Versionen jedoch erweiterte Funktionen, eine bessere Zuverlässigkeit und einen hervorragenden Kundensupport. Die Wahl hängt von den spezifischen Bedürfnissen und dem Budget des Benutzers ab.

Wie sammelt man effektiv Daten mit einem Webbrowser?

Web-Scraping-Browsererweiterungen können die Datenerfassung erheblich vereinfachen. Sie ermöglichen Benutzern das einfache Abrufen von Informationen von Webseiten, ohne dass zusätzliche Software erforderlich ist. Diese Erweiterungen sind oft benutzerfreundlich und können ein guter Ausgangspunkt für diejenigen sein, die neu in der Welt des Web Scraping sind.

Die Auswirkungen von Web Scraping auf das Geschäftsdatenmanagement

Web Scraping hat erhebliche Auswirkungen auf das Datenmanagement in Unternehmen. Es ermöglicht eine schnelle und effektive Datenerfassung, die für fundierte Entscheidungen, Marktanalysen und Wettbewerbsinformationen unerlässlich ist. Die gewonnenen Daten können dabei helfen, neue Trends zu identifizieren, Marketingstrategien zu optimieren und das Kundenerlebnis zu verbessern.

Zukünftige Trends beim Web Scraping

Die Zukunft des Web Scraping geht in Richtung einer stärkeren Integration von künstlicher Intelligenz und maschinellem Lernen, was eine gezieltere und kontextuellere Datenerfassung ermöglicht. Das Scraping in Echtzeit wird ebenfalls immer wichtiger, da es sofortige und aktuelle Daten bietet. Diese Entwicklungen versprechen, Web Scraping noch leistungsfähiger und anpassungsfähiger an die sich ändernden Bedürfnisse von Unternehmen und Einzelpersonen zu machen.

Zusammenfassung der wichtigsten Punkte

- Web Scraping verstehen: Es ist ein unverzichtbares Tool zum Extrahieren von Daten von Websites.

- Softwareauswahl: Hängt von der Benutzerfreundlichkeit, den Funktionen, dem Kundensupport und den spezifischen Bedürfnissen ab.

- Legalität und Ethik: Es ist wichtig, die Gesetze und Nutzungsbedingungen der Websites zu respektieren.

- Vorteile einfach zu bedienender Scraper: Machen Sie das Scraping für alle zugänglich.

- Kostenlos oder kostenpflichtig: Die kostenpflichtigen Versionen bieten mehr Funktionen und Zuverlässigkeit für komplexe Aufgaben.

- Verwenden von Browsererweiterungen: Vereinfacht die Datenerfassung für Anfänger.

- Auswirkungen auf Unternehmen: Verbessert die Entscheidungsfindung und Marktanalyse.

- Zukünftige Trends: KI und Echtzeit-Scraping werden eine zunehmende Rolle spielen.